어쩌다보니 백수가 되었다.

첫 3개월간 스트레스도 받고

면접에서 계속 떨어지며 자존감이 낮아지며 힘든 시기를 보냈다.

사람은 적응의 동물이랄까?

취직에 대한 마음을 내려놓으니

백수의 생활을 매우 매우 잘 보내고 있다.

일어나고 싶을때 일어나고...

몸 찌뿌등하면 헬스장 가고

드라마에 빠져서 시간가는 줄도 모르고... 게임도 하고 등등

지금은 오히려 취업을 좀 늦게 하거나... 좀 쉬다가 새로운 일을 준비해볼까 생각을 하는 중이다.

삶이란 참 웃기다

마음가짐 하나 바뀌었을 뿐인데

지옥에서 천국으로 변하다니

백수는 시간이 정말정말정말 많다.

드라마를 아무리 봐도 시간이 남는다.

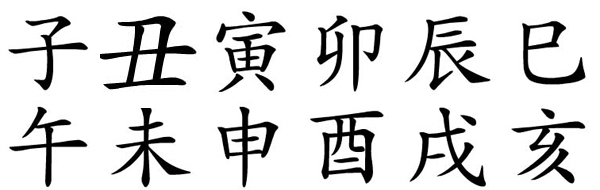

요즘 난 그 남는 시간에 나는 블로그에 있는 사주 관련된 글을 읽고 있다.

곧 있으면 입춘(立春)이다.

역학에서는 입춘부터 새로운 1년이 시작된다고 한다.

곧 갑진(甲辰)년이 시작이 된다.

청룡의 해... 갑진년

물론 나도 신년운세를 보긴 했다.

내 사주는 금수(金水)가 강한 사주고 목(木)을 용신으로 사용하는 사주라

강한 목이 들어오는 갑진년은 긍정적이다.

신자진 수국은 나에게 도충으로 오화를 불러와 도움이 된다고 한다.

나는 일반격이 아니라 외격이기에...

2024년 갑진년은 나에게 매우 유리한 해이다.

재물적으로도 직업적으로도...

그렇다면 나는 2024년에 돈을 많이 벌고 누구나 원하는 직장에 들어가게 될까?

정답은 "yes or no"이다.

그럴수도 있고 아닐 수도 있다는 말이다.

여기서 사주팔자에 대해서 생각의 차이가 발생한다.

사주팔자는 단순히 운을 보는 것이다.

이벤트나 사건을 맞히는 것이 아니라는 것이다.

쉽게 말해서 유리한지 불리한지 가능성만 보여주는 것이다.

이벤트나 사건을 맞히려면 신점을 보러가는게 맞다.

오늘 어떤 사주 블로그 글에서 이런 비유가 있었다.

"호랑이가 찾아와서 올해는 노루를 잡을 수 있을까요?라고 물어보면 어떻게 대답해야 하나"

님이라면 어떻게 대답하시겠습니까? ㅋㅋ

간단한 생각의 변화로 삶이 천국과 지옥을 넘나드는 것처럼

행복과 불행은 종이 한장 차이가 아닐까 생각이 드는 요즘이다.

갑진년의 기운이 조금씩 들어와서 그런가

취업을 꼭 하지 않아도 된다는 마음이 들고 있다.

그냥 간단한 알바하면서 새로운 길을 준비할 수도 있고

가끔 지원서 한두개씩 넣으면서 어쩌다가 하나 얻어 걸릴 수도 있고 ㅎㅎ

대기업에 가서 느낀건 돈과 복지가 인생의 전부는 아니라는 것을 느꼈고

중견기업에서 느낀건 연봉이 적어도 좋은 사람들과 일하는게 너무너무 즐겁다는 것을 느꼈다.

다음은 어떤걸 경험하게 될까?

나는 역학 글이 왜 재밌을까?

나는 내가 보지 못한 시각을 깨닫고 새로운 시각으로 세상을 바라보는 게 너무 즐겁다.

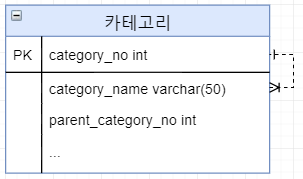

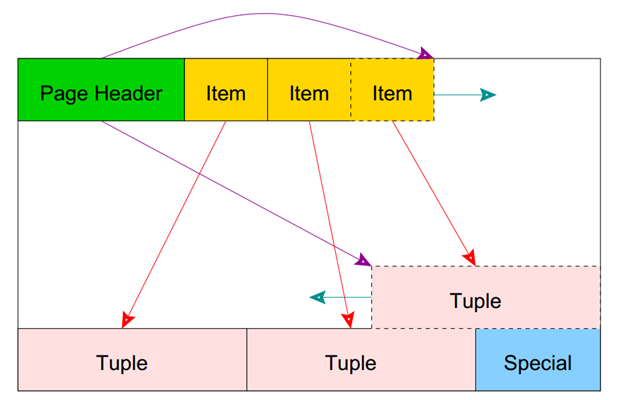

예를 들어, 사주에는 충(沖)이라는 개념이 있다.

충은 충돌할때 충이 아니다.

용어로 대대라고 한다. (반대x, 마주 대하다o)

짝이라고 볼 수도 있다.

너가 있으면 내가 있는 것처럼

남자가 있으면 여자가 있는 것처럼

여당이 있으면 야당이 있는 것처럼

천간의 합 = 지지의 충 <오운육기(五運六氣)>

점성술에서 말하면 어포지션을 말하는 것이다.

점성술에서 1하우스는 나를 뜻한다.

그리고 어포지션 7하우스는 너를 뜻한다.

7하우스는 결혼, 배우자를 뜻한다.

즉, 나와 배우자는 짝이기도 하면서 서로 마주 대하는 어포지션을 말하는 것이다.

신기하지 않나요?

사주와 점성술에서 말하는 대대라는게?

그리고 충이라는건 1대 1관계에서만 된다.

균형이 맞아야 산출물이 나온다.

이자불충오(二子不沖午)

자수가 2개이면 오화와 충이 안된다라는 말이다.

충이 성립이 되지 않아서 자오충 소음군화가 발생하지 않는다는 뜻이다.

이런건 쟁충(爭沖)이라고 하는데 좋은건 아니다 ㅎㅎ

사주가 좋든 좋지 않든 운을 좋게 만드는 방법이 있다.

쉽게 말해 개운법!!!

그건 바로 사람이다.

나에게 필요한 글자를 가진 사람을 만나면 좋지 않은 운을 피할 수 있고

반대로 나를 더 힘들게 만드는 글자를 가진 사람은 운을 더 좋지 않게 만든다.

이러니 어떻게 단순히 사주팔자만을 가지고 그 사람의 인생에 대해서 결정을 내릴 수 있겠는가?

그래서 결국 돌고 돌아 인생은 알 수 없다는 말이다.

새옹지마(塞翁之馬)라는 고사성어를 알지 않은가?

변방의 노인의 말이 도망갔지만, 야생마들을 이끌고 돌아왔고

노인의 아들이 야생마를 타다가 떨어져 절름발이가 되었지만, 전쟁을 피할 수 있었다.

좋은 일이 나쁜 일이 되기도 하고

나쁜 일이 좋은 일이 되기도 한다.

삶이란 결코 예측할 수 없다

그걸 예측하고 맞히는건 그건 신이지 인간이 아니지..

그래도 나처럼 간절히 무언가를 바라는 사람들이 있을 것이다.

그럴 땐... 그냥 기도를 해라.

하느님이든 부처님이든 길거리 굴러다니는 돌에 하든

간절히 정말 간절히 기도를 해라.

간절함이 하늘에 닿으면 이뤄질지도 모르니 ㅎㅎ

모두들 새해에 복 많이 받고 원하는 일 모두 이뤄지길~

Happy New Year~!!!

'일상' 카테고리의 다른 글

| [일상] 개굴개굴 (0) | 2024.06.16 |

|---|---|

| [일상] 헬스장 창문 너머 (1) | 2024.03.17 |

| [일상] 나의 신(神) (0) | 2021.12.12 |

| [일상] 솔라리턴 (0) | 2018.12.19 |

| [일상] 명동성당 아침 (2) | 2018.10.30 |